Il termine “disinformazione” oggi sembra essere fuori moda, sostituito dal termine “fake news” decisamente più di moda. Mentre il termine anglofono indica il mezzo utilizzato per influire sull’opinione pubblica, parlare di “disinformazione” mette l’accento sulle finalità intrinseca nella fabbricazione di notizie false. Ci si dovrebbe inoltrare, a questo punto, sulla corretta definizione di cosa si intenda per notizia “vera” o “falsa”, questo perché spesso, per rendere verosimile una notizia falsa, viene arricchita con fatti veri, che possono però essere relativi a tempi, luoghi e persone diversi rispetto a quelli riportati. Inoltre, il racconto dei “fatti” non è sempre totalmente separabile dall’opinione di chi racconta, dal momento che la costruzione stessa di un racconto implica l’uso di aggettivi e avverbi che non possono essere neutrali. Se però dovessimo spogliare i fatti del racconto, sarebbe ben difficile potersi appassionare alle vicende del mondo.

Queste riflessioni portarono a metà del ‘800 alla definizione del termine “social engineering”, cioè alla formalizzazione della possibilità di poter manipolare la società, ed in particolare il suo comportamento economico, attraverso l’uso di tecniche di comunicazione opportunamente confezionate allo scopo di ottenere il risultato desiderato. Non necessariamente si tratta di fabbricare notizie false, o di arricchire dei fatti con dettagli non necessariamente veritieri, ma si tratta principalmente di riuscire a diffondere un racconto di fatti ed avvenimenti che susciti specifici comportamenti negli individui che lo leggono, lo ascoltano o lo vedono.

Un interessante articolo apparso di recente sulla rivista Computers and Security1 mette in evidenza i tre principi di base dell’ingegneria sociale: asimmetria di conoscenze, dominio tecnocratico, sostituzione dei fini.

L’abilità di modificare i comportamenti sociali fa leva sulle maggiori conoscenze e competenze tecniche possedute da chi vuole assumere un ruolo di controllo di un altro gruppo di individui, che verrà guidato a trovare conveniente, consapevolmente o inconsapevolmente, agire in modo da raggiungere le finalità del gruppo che utilizza tecniche di ingegneria sociale. La pubblicità commerciale è uno degli esempi più chiari di utilizzo di queste tecniche.

Oggi assistiamo a un ulteriore raffinamento delle tecniche di disinformazione, o più precisamente di manipolazione dell’informazione, come ben descritto nel recente documento pubblicato da un gruppo di studio costituito congiuntamente dal Ministero per l’Europa e gli Affari Esteri e il Ministero delle Forze Armate in Francia2. Di questo cambio di strategia un ruolo da pioniere è stato giocato dalla Russia dai primi del ‘900. Per conquistare la fiducia di popolazioni di altre nazioni, le campagne di (dis)informazione hanno avuto l’obiettivo non tanto di esaltare i benefici del comunismo, quanto di esaltare gli aspetti di debolezza e criticità della cultura di governo dei paesi obiettivo dell’attacco, mostrandosi come possibile àncora di salvezza3. Tuttavia l’utilizzo di forme di censura volte a bloccare tentativi di disinformazione anche attraverso il finanziamento diretto di attività giornalistica di inchiesta, finisce per fare il gioco della campagna disinformativa, perché entrambe accomunate dalla ingerenza da parte dello Stato nella sfera della libera informazione: controllando e limitando la libertà di espressione paradossalmente si rende vero il contenuto delle campagne di disinformazione, che spesso si basano sull’accusare il governo “nemico” di controllo dell’informazione.

Oggi assistiamo a un ulteriore raffinamento delle tecniche di disinformazione, o più precisamente di manipolazione dell’informazione, come ben descritto nel recente documento pubblicato da un gruppo di studio costituito congiuntamente dal Ministero per l’Europa e gli Affari Esteri e il Ministero delle Forze Armate in Francia2. Di questo cambio di strategia un ruolo da pioniere è stato giocato dalla Russia dai primi del ‘900. Per conquistare la fiducia di popolazioni di altre nazioni, le campagne di (dis)informazione hanno avuto l’obiettivo non tanto di esaltare i benefici del comunismo, quanto di esaltare gli aspetti di debolezza e criticità della cultura di governo dei paesi obiettivo dell’attacco, mostrandosi come possibile àncora di salvezza3. Tuttavia l’utilizzo di forme di censura volte a bloccare tentativi di disinformazione anche attraverso il finanziamento diretto di attività giornalistica di inchiesta, finisce per fare il gioco della campagna disinformativa, perché entrambe accomunate dalla ingerenza da parte dello Stato nella sfera della libera informazione: controllando e limitando la libertà di espressione paradossalmente si rende vero il contenuto delle campagne di disinformazione, che spesso si basano sull’accusare il governo “nemico” di controllo dell’informazione.

Conseguentemente, la natura stessa dei servizi di disinformazione sta mutando, come riportato nel recente articolo di Wired nel quale si presenta la 77ma brigata del Regno Unito4. È una vera e propria centrale di produzione di materiale informativo multimediale finalizzato a catturare l’interesse e a influenzare l’opinione pubblica seguendo le regole ben note nell’uso dei social network nel settore pubblicitario. Obiettivo è quello di creare comunità di utenti della rete che si fidano delle notizie e comunicazioni diramate dai canali ufficiali.

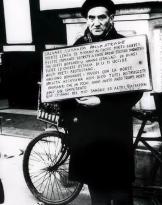

L’evoluzione delle tecnologie di creazione e manipolazione di contenuti multimediali, che rendono la narrazione ancora più efficace nel rendere “vera” una notizia, hanno reso le attività di ingegneria sociale ancora più sofisticate e più subdole. La difficoltà a distinguere la verità di un’immagine o un video discende non solo dalle ampie possibilità di montaggi, ritocchi e fabbricazione, ma anche dalle potenzialità dei social network che consentono la diffusione di notizie dal basso, senza apparenti filtri, e pertanto ritenute più veritiere di quelle presentate dagli organi di informazione ufficiali. Per cui la “verità” discende non dalla verifica delle fonti, ma dalla comunità che ne supporta l’opinione. Uno dei social network che è stato maggiormente sfruttato nelle campagne disinformative è twitter attraverso l’uso di programmi automatici (chiamati bot, da robot) che creano profili falsi perfettamente verosimili che ingaggiano delle discussioni basandosi sull’analisi degli argomenti di tendenza in modo da infiammare il dibattito e coinvolgere rapidamente un numero elevato di utenti veri che inconsapevolmente danno credibilità al contenuto5.

Tornando al tema dei contenuti multimediali a supporto del racconto disinformativo, la difficoltà a rilevare falsi è riportata da alcuni anni in diversi articoli tecnico-scientifici. I primi bersagli sono proprio i giornalisti i cui strumenti a disposizione per verificare i fatti sono ancora carenti se rapportati con il livello di sofisticazione raggiunta dai software per la creazione di falsi verosimili6. È il caso ad esempio del lavoro svolto da bellingcat7 nel sottoporre le notizie alla verifica dei fatti attraverso l’analisi delle fonti disponibili e la loro attendibilità e affidabilità. Compito tutt’altro che semplice, come testimoniato ad esempio nel caso della notizia dell’attacco chimico in Siria del 7 Aprile 2018 riportato dai Caschi Bianchi (fotogramma), che alcuni mezzi di comunicazione russi hanno presentato come “fake news” attraverso immagini e video che provano l’esistenza di un teatro di posa cinematografico per fabbricare fake news. Secondo l’indagine effettuata da Bellingcat Il teatro di posa esiste, ma non è collegato con l’attacco chimico8, e tuttavia l’assenza di testimoni terzi sul posto ha reso il compito di accertare i fatti estremamente arduo dovendo attendere il mese di Luglio per avere i risultati della verifica compiuta dall’organizzazione internazionale per la proibizione delle armi chimiche (OPCW)9. Il risultato è che le accuse reciproche di notizie false sulla Siria legittimano tutte le parti in conflitto ad avviare bombardamenti ancor prima di verificare i fatti, come accaduto il 14 Aprile con bombardamenti da parte di USA, UK e Francia10, poche ore prima che la missione OPCW potesse avviare le attività di accertamento dell’effettiva presenza di tracce di attacchi chimici. Ne consegue una sempre maggiore convinzione nell’opinione pubblica che non esistano “fatti” ma solo “narrazioni” che ciascuno può fabbricare per motivare le proprie azioni.

Tornando al tema dei contenuti multimediali a supporto del racconto disinformativo, la difficoltà a rilevare falsi è riportata da alcuni anni in diversi articoli tecnico-scientifici. I primi bersagli sono proprio i giornalisti i cui strumenti a disposizione per verificare i fatti sono ancora carenti se rapportati con il livello di sofisticazione raggiunta dai software per la creazione di falsi verosimili6. È il caso ad esempio del lavoro svolto da bellingcat7 nel sottoporre le notizie alla verifica dei fatti attraverso l’analisi delle fonti disponibili e la loro attendibilità e affidabilità. Compito tutt’altro che semplice, come testimoniato ad esempio nel caso della notizia dell’attacco chimico in Siria del 7 Aprile 2018 riportato dai Caschi Bianchi (fotogramma), che alcuni mezzi di comunicazione russi hanno presentato come “fake news” attraverso immagini e video che provano l’esistenza di un teatro di posa cinematografico per fabbricare fake news. Secondo l’indagine effettuata da Bellingcat Il teatro di posa esiste, ma non è collegato con l’attacco chimico8, e tuttavia l’assenza di testimoni terzi sul posto ha reso il compito di accertare i fatti estremamente arduo dovendo attendere il mese di Luglio per avere i risultati della verifica compiuta dall’organizzazione internazionale per la proibizione delle armi chimiche (OPCW)9. Il risultato è che le accuse reciproche di notizie false sulla Siria legittimano tutte le parti in conflitto ad avviare bombardamenti ancor prima di verificare i fatti, come accaduto il 14 Aprile con bombardamenti da parte di USA, UK e Francia10, poche ore prima che la missione OPCW potesse avviare le attività di accertamento dell’effettiva presenza di tracce di attacchi chimici. Ne consegue una sempre maggiore convinzione nell’opinione pubblica che non esistano “fatti” ma solo “narrazioni” che ciascuno può fabbricare per motivare le proprie azioni.

A livello accademico, il gruppo di ricerca in “Propaganda computazionale” presso l’Oxford Internet Institute dell’Università di Oxford11 sta studiando l’influenza che i servizi di disinformazione di nazioni avversarie possono aver avuto durante le campagne elettorali in diverse nazioni a partire dal 2012. L’ultimo rapporto dello scorso 17 Dicembre, commissionato dal Senato degli Stati Uniti, si concentra sulle attività svolte dal dipartimento russo IRA (Internet Research Agency) per influenzare la politica americana nel periodo 2012-2018. L’analisi dei tweet mostra come il mondo virtuale sia diventato un attraente terreno di scontro fra nazioni grazie alla capacità di creare rapidamente movimenti nell’opinione pubblica. Se le campagne “tradizionali” di disinformazione hanno come obiettivo principale la legittimazione di conflitti armati che generano vittime fra quei civili che si vuole difendere da poteri dittatoriali, la novità delle campagne condotte sui social media risiede nell’obiettivo di causare il ribaltamento del potere politico senza il ricorso ad azioni militari dall’esterno, ma attraverso l’esasperazione dei conflitti interni. A seconda della nazione obiettivo, questo si risolve o in un risultato elettorale gradito alla nazione attaccante, o in una azione violenta, laddove non vi sia fiducia nei meccanismi elettorali.

È evidente come il progresso tecnologico che consente di estendere le vite dei singoli e delle nazioni oltre i confini dei 5 sensi, sta profondamente trasformando l’origine e la natura dei conflitti fra le nazioni spostandola in modo sempre più massiccio sul campo informativo. In questo terreno risulta spesso alquanto arduo distinguere i fatti dalle costruzioni fantasiose soprattutto nel momento in cui per comunicare i fatti si vuole usare lo stile della narrazione, molto efficace dal punto di vista della comunicazione emotiva, ma estremamente vulnerabile al rigore scientifico di verifica della veridicità. Ne consegue che si diventa più facilmente vittime di campagne disinformative quanto meno si investe nella educazione all’uso del sapere razionale, nel dare cioè a ciascun cittadino la possibilità di accedere direttamente a fonti informative con descrizioni tecniche, che certo richiedono pazienza e conoscenza e possono risultare “noiose”, ma sono l’unico antidoto contro l’uso indiscriminato dello stile narrativo, che nasconde la volontà di sfruttare e ampliare l’asimmetria di conoscenze, e il dominio tecnocratico. La presunta finalità dello stile narrativo di creare minor distanza dai cittadini e ottenere consenso nasconde in realtà la finalità opposta, quella cioè di tenere i cittadini sempre più lontani dai meccanismi di funzionamento e di governo, rendendo complessivamente la società più vulnerabile.

1J. Hatfield, “Social Engineering in Cybersecurity: The evolution of a concept,” Computers & Security, 2018.

11https://comprop.oii.ox.ac.uk

Foto: U.S. Air National Guard (esercitazione al soccorso del New Jersey Army National Guard) / web